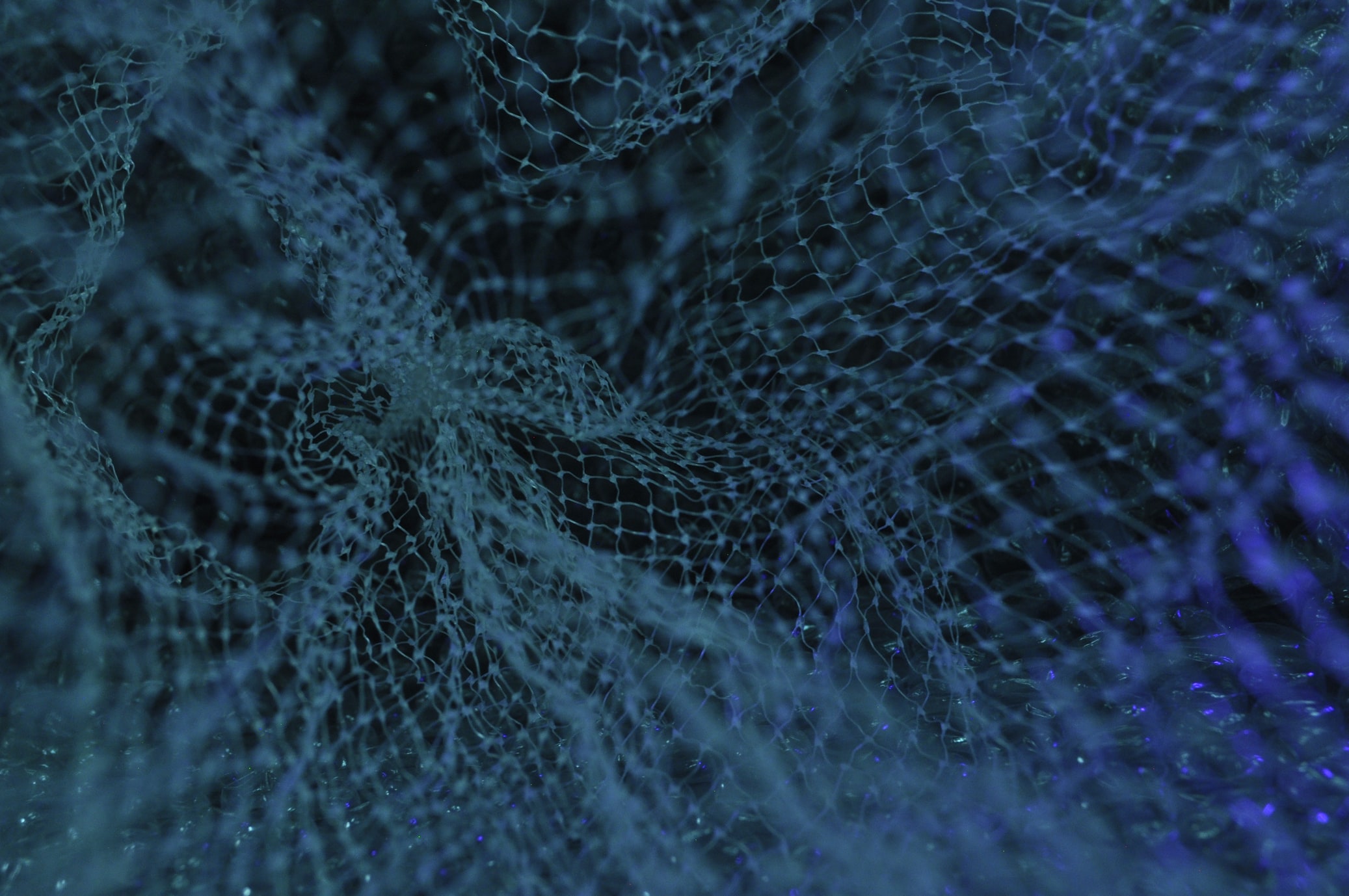

Esta hiperred podría definirse como la estructura “suprema” de todas las redes neuronales.

Expertos de la Universidad de Guelph en Ontario, liderados por Boris Knyazev, han diseñado una “hiperred” neuronal que podría acelerar el proceso de entrenamiento de la inteligencia artificial. Esta hiperred podría definirse como la estructura “suprema” de todas las redes neuronales.

Según los investigadores, cuando una nueva red neuronal profunda no está diseñada y entrenada para alguna tarea, la hiperred predice los parámetros de esta nueva red en fracciones de segundo y, en teoría, podría hacer que el entrenamiento sea innecesario. Debido a que la hiperred aprende los patrones extremadamente complejos en los diseños de redes neuronales profundas, el trabajo, naturalmente, también puede tener implicaciones teóricas más profundas.

Por ahora, la hiperred funciona sorprendentemente bien en ciertos entornos, pero todavía hay espacio para que crezca, lo cual es natural dada la magnitud de su naturaleza. Según Petar Veličković, investigador de la firma londinense DeepMind, si pueden descubrir cómo encauzar dicho crecimiento, “esto tendrá un gran impacto en todos los ámbitos para el aprendizaje automático”.

Actualmente, los mejores métodos para entrenar y optimizar redes neuronales profundas son variaciones de una técnica llamada descenso de gradiente estocástico (SGD, por sus siglas en inglés). El entrenamiento implica minimizar los errores que comete la red en una tarea determinada, como el reconocimiento de imágenes. Un algoritmo SGD procesa muchos datos etiquetados para ajustar los parámetros de la red y reducir los errores o pérdidas. El descenso de gradiente es el proceso iterativo de descender desde valores altos de la función de pérdida hasta un valor mínimo, que arroja valores de parámetro suficientemente buenos (o, a veces, incluso los mejores posibles).

Pero esta técnica solo funciona una vez que tiene una red para optimizar. Para construir la red neuronal inicial, generalmente compuesta por múltiples capas de neuronas artificiales que conducen de una entrada a una salida, los ingenieros deben confiar en la intuición y en reglas más o menos generales. Estas arquitecturas pueden variar en cuanto al número de capas de neuronas, el número de neuronas por capa, etc.

No obstante, para Veličković, este desarrollo representa un avance extraordinario en el mundo de las redes neuronales. “Los resultados son definitivamente súper impresionantes”, expresó. “Básicamente, lograron reducir de forma notable los costos energéticos”.

Por su parte, Thomas Kipf, investigador de Google Brain, asegura que este podría ser el punto de partida para el desarrollo de nuevas redes neuronales.

“Este trabajo provee evidencia de que existen patrones similares en diferentes tipos de arquitecturas, y también nos enseña que es posible aprender cómo transferir conocimiento de una arquitectura a otra diferente”, afirmó. “Eso es algo que podría revolucionar el campo de las redes neuronales e inspirar una nueva teoría” agregó.